NVIDIA GeForce RTX 2080 Ti性能随手测

Cortex社区的小伙伴大家好!今天给大家带来一个特别的内容分享。

首先介绍一下背景:

感谢Cortex社区十分给力的神秘小伙伴协助联络,我们在9月23日下午顺利拿到了NVIDIA最新发布的旗舰显卡GeForce RTX 2080 Ti。这款让游戏爱好者和硬件爱好者魂牵梦绕的全新旗舰,终于来到了Cortex Labs的办公室。我们后续将会对2080Ti进行深度的测试。

当然,游戏性能等方面的表现,已经有众多评测机构做过。Cortex Labs更关心的是2080 Ti的机器学习性能和挖矿表现相对于1080 Ti显卡的提升。

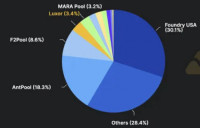

拿到显卡之后,运营的小伙伴已经按耐不住,用最快的速度,对2080 Ti的挖矿性能做了一个简单的测试。并且同时运行了一张1080 Ti显卡作为参考和对比。我们先从这一个角度,来看一下2080 Ti在挖矿性能上的提升。

我们先看一下2080 Ti的产品外观。

这部分不多介绍,直接看图。我们拿到的是GIGABYTE的非公版卡,具体产品型号是:GIGABYTE GeForce RTX 2080 Ti Windforce OC 11G。

好了,下面来给大家看一下这款产品的实拍图,并且和1080 Ti进行一下对比。(说明一下,1080 Ti是Cortex Labs用来做深度学习的MSI 1080 Ti涡轮风扇,具体产品型号是:MSI GeForce GTX 1080 Ti AERO 11G OC)

(2080 Ti外包装)

(1080 Ti和2080 Ti实拍正面对比)

(1080 Ti和2080 Ti实拍厚度对比)

(细节参数来自GIGABYTE官网)

看完了产品,要对测试环境进行一下准备。

我们使用的是办公室现成的SuperMicro SuperServer 4028GR-TR机器学习服务器作为测试平台,服务器基础配置如下:

主板:Super X10DRG-O+-CPU

CPU:intel® Xeon® processor E5-2600 v4†/ v3 family (up to 160W TDP) *

Dual Socket R3 (LGA 2011)

内存:2400 MHZ DDR4 SDRAM 72-bit

系统:Linux Ubuntu 18.04

然后交代一下测试的挖矿算法:

一般来说,GPU做挖矿性能测试,会主要选择ETH的Ethash算法或者ZEC的Equihash算法。但目前都有矿机厂商针对这两个算法研发并量产了ASIC矿机。不过,Ethash算法由于对显存有比较高的需求,Ethash ASIC矿机对GPU挖矿的影响并不是很大,而Equihash ASIC矿机则对GPU挖矿的影响却很大(A9、Z9 mini等机器)。因此,我们这里选择ETH的Ethash算法进行测试。

最后还要介绍一下挖矿软件的选择:

我们最初选择相对矿工更熟悉的Claymore挖矿软件进行测试。但在实际测试中,Claymore还没有对2080Ti进行完美适配。最终我们选择EthMiner作为挖矿软件。

准备工作都已经完毕,我们正式把两个显卡全部装到服务器机上去,并安装好驱动。

1080 Ti的驱动版本为:NVIDIA-Linux-x86_64-390.87.run

2080 Ti的驱动版本为:NVIDIA-Linux-x86_64-410.57.run

(1080 Ti和2080 Ti已经全部安装好)

激动人心的时刻马上就要到了!!!

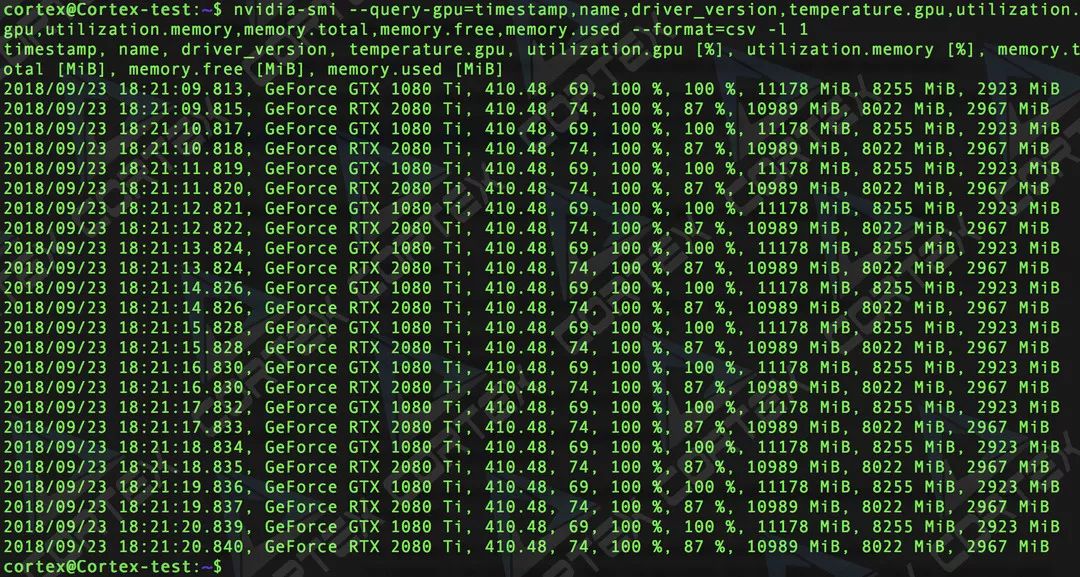

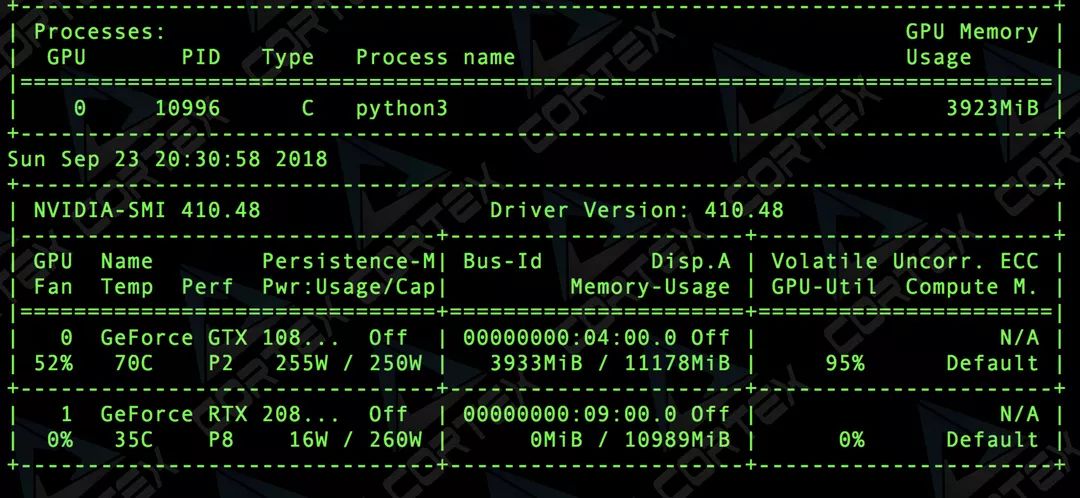

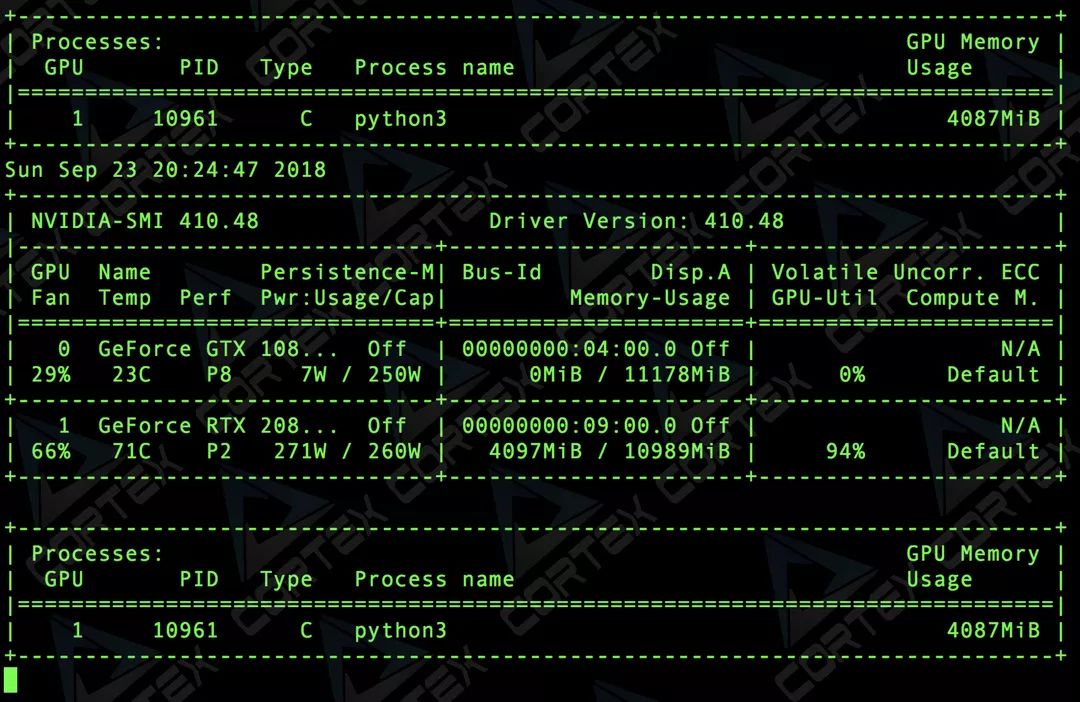

开机,我们可以看到,两个卡驱动都正常。

(Linux系统下查看GPU信息,显示信息不完整)

(再来一张完整信息的图)

运行EthMiner,两个卡都能顺利挖矿,并显示出本地算力。趋于稳定后,我们截图来看。

(GPU0为2080 Ti,GPU1为1080Ti)

从图中我们可以看到,两款显卡在均未超频情况下,在Ethash算法下的算力表现分别为:

1080 Ti 算力:32.46 MH/s 功耗:212W

2080 Ti 算力:50.90 MH/s 功耗:257W

这里我们还能看到,2080 Ti相对于1080 Ti的提升还是相当明显的,Ethash算法下的算力提升达到了56.8%。而功耗则只增加21.2%。

不过,在过去使用1080 Ti挖矿的过程中,其实已经有很多对1080 Ti算力进行优化的工具。而目前2080 Ti则还没有类似的程序出现。我们选择一款常用的软件对1080 Ti进行算力优化后,看看差距还有多少?

(使用了1080 Ti算力优化工具后,两个显卡的算力表现)

开启了优化工具后,我们可以看到,GPU1(也就是1080 Ti)的算力已经从32.46 MH/s提升到了45.19 MH/s,提升了12.73 MH/s。而此优化工具,对2080 Ti则没有优化效果。这样一来,1080 Ti和2080 Ti在Ethash算法下的算力差距只有5.7 MH/s左右。

测试到这里,可能大家会吐槽,难道2080 Ti的性能提升只有这么一点?

其实并不是这样的,1080 Ti的产品周期毕竟已经进入尾声,经过这么多年的沉淀,已经有无数人针对这款产品进行了反反复复的提升和优化。而2080 Ti目前还没有太多人拿到产品,更谈不上进行优化。虽然我们这次测试最终的差距结果不是很大,但这是一个“上代产品优化到极致”与“新生产品纯粹原生态”的较量,并且只是在Ethash算法下的性能表现。因此,这个数据测试也仅对当前时间的特定算法下有参考意义。

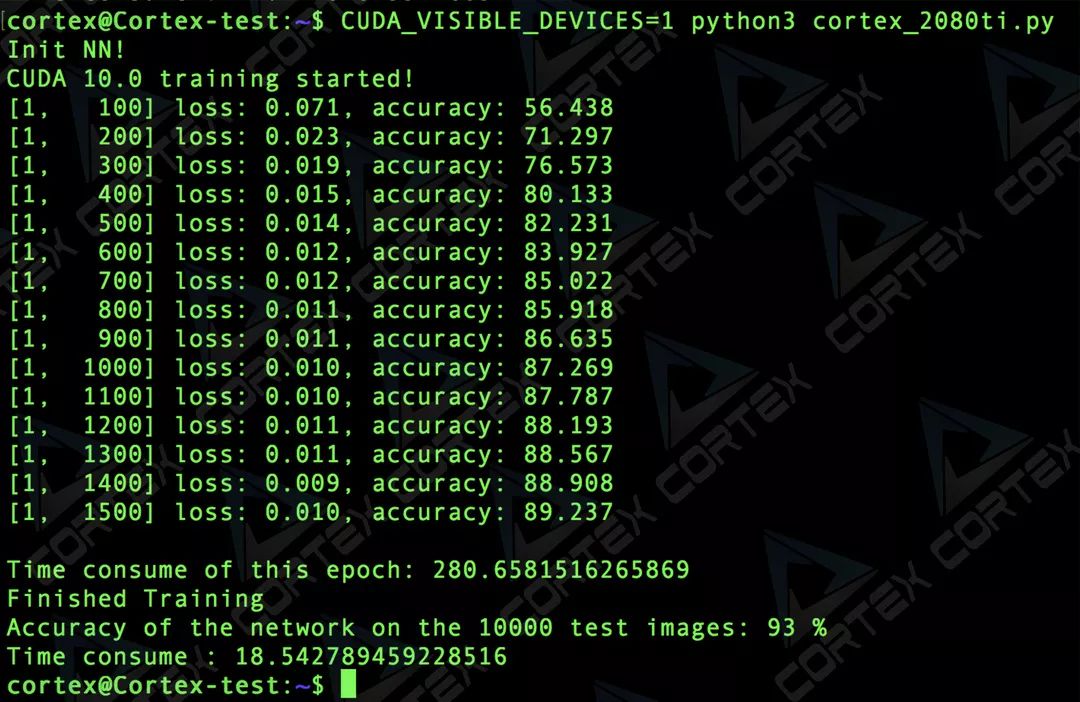

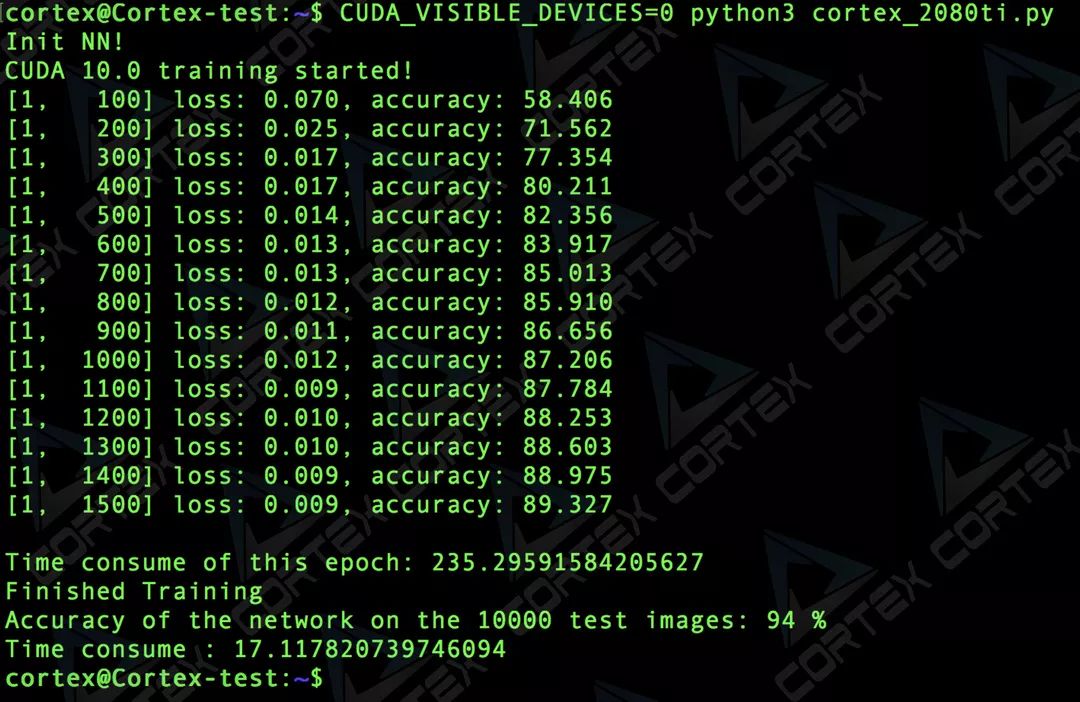

就在我们运营组的小伙伴测试完挖矿的性能之后,AI部门的小伙伴也迫不及待开始部署机器学习任务到服务器上。用最快的速度,在服务器上实现了以下操作(描述来自AI研发的小伙伴):在cifar10数据集上,使用resnet50进行图片分类任务(分类数10类,图片尺寸resize到(224,224))。在最新的cuda 10.0+pytorch 0.4.1+cuDNN 7.3 环境上,对 2080ti和1080ti两块显卡分别进行了训练+推断的测试。测试的结果如下:

(1080 Ti运行中)

(1080 Ti的训练时间约为280.66s,推断的时间约为18.54s)

(2080 Ti运行中)

(2080 Ti的训练时间约为235.30s,推断的时间约为17.12s)

通过以上测试,我们发现,2080 Ti相对于1080 Ti,将训练耗时缩短了16.16%;将推断耗时缩短了7.7%。

不过,考虑到现有的软件支持还不够成熟,此次的结果只是一个初步的参考。这个结果让我们感到差强人意。当然,后续我们还会有更深度的测试,会把我们开发团队的测试进展,分享给全社区的小伙伴。

声明:此文出于传递更多信息之目的,并不意味着赞同其观点或证实其描述。本网站所提供的信息,只供参考之用。